La regulación europea de IA, semáforos e impacto global

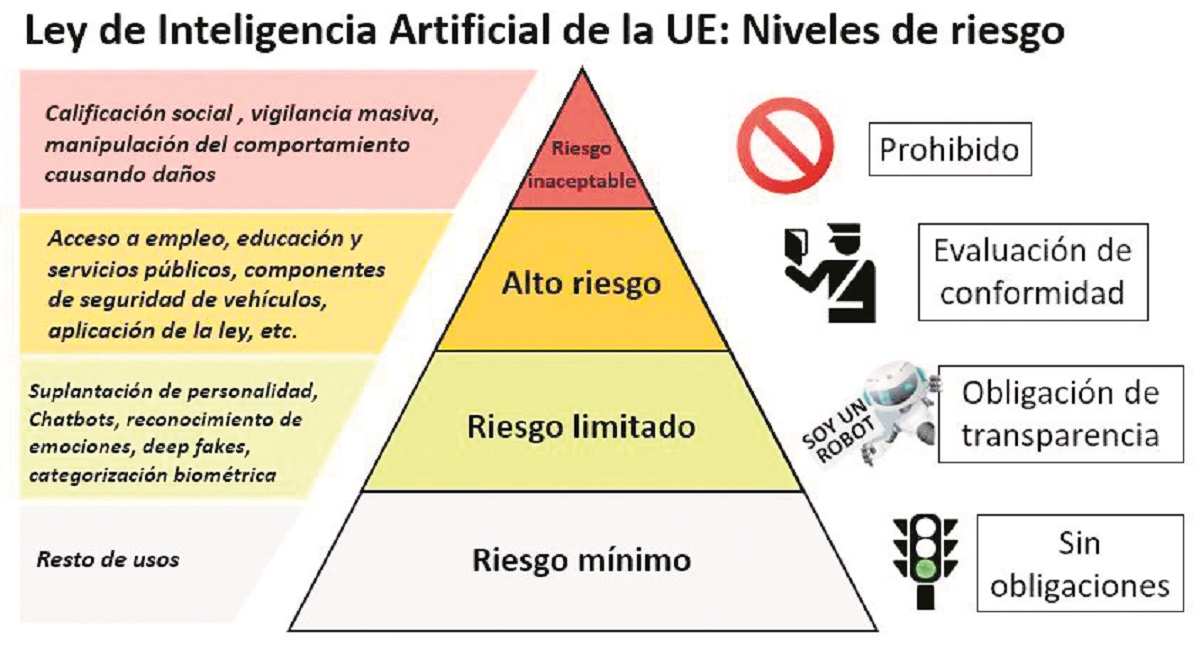

Establece un interesante sistema que incluye cuatro niveles de riesgo, que marcan los diferentes niveles de peligrosidad y, en consecuencia, de permisibilidad.

La regulación de la inteligencia artificial es un fenómeno en desarrollo, la Unión Europea (UE) está a la vanguardia y ha dado un paso significativo hacia el futuro, al establecer la primera ley integral con reglas armonizadoras en ese ámbito.

La Ley de IA busca garantizar la seguridad, respeto de los derechos fundamentales, fomentar la innovación, proteger la democracia y el medio ambiente, mientras impulsa la innovación. Promueve una adopción de IA fiable y centrada en el ser humano. Establece obligaciones para proveedores y usuarios en función de los niveles de riesgo de la IA, crea Órganos de control y aplicación, y costosas multas para quienes incumplan.

Ahora bien, establece un interesante sistema de semáforos que incluye cuatro niveles de riesgo, los que marcan los diferentes niveles de peligrosidad y, en consecuencia, de permisibilidad. Rojo: inaceptable, Amarillo alto y limitado; Verde: mínimo.

Semáforo Rojo: prohíbe los sistemas de IA de riesgo inaceptable , aquellos que amenacen la seguridad y derechos de las personas, como la manipulación cognitiva o la puntuación social basada en características personales o creencias. Son prohibidos los juguetes activados por voz que fomentan comportamientos peligrosos en los niños; la clasificación de personas en función de su comportamiento, estatus socioeconómico o características personales; sistemas de identificación biométrica en tiempo real y a distancia, como el reconocimiento facial: actuación policial predictiva individual; reconocimiento de emociones en el lugar de trabajo y en las instituciones educativas; todos los sistemas de categorización biométrica por creencias políticas, religiosas, filosóficas o por su raza y orientación sexual. Se busca evitar la manipulación del comportamiento humano. Todo ello, a menos que estén autorizados por la ley con fines de seguridad nacional, pensemos aquí nuestras cámaras de seguridad con reconocimiento biométrico y aplicación de I.A (¿cuándo S.rojo y cuándo S.amarillo? ¿Se encuentra regulado?).

Semáforo amarillo: en cambio, no se prohíbe, pero deben cumplir con estrictas regulaciones y evaluaciones de conformidad los sistemas de IA de Alto Riesgo en sectores críticos como salud, transporte y seguridad de los productos tales como los juguetes, aviación, automóviles, dispositivos médicos y ascensores, sistemas de conducción autónoma o aquellos utilizados por los bancos para evaluar la solvencia y la calificación crediticia de los ciudadanos. Para algunos se trata de una luz naranja en el semáforo, puesto que estos sistemas se pueden implantar siempre que se reúnan los requisitos que el propio reglamento. Son sistemas de IA pertenecientes a ocho ámbitos específicos que deben registrarse en una base de datos de la UE y someterse a una evaluación de conformidad que examina la calidad de los conjuntos de datos para minimizar los riesgos y los resultados discriminatorios, la documentación y el mantenimiento de registros para la trazabilidad, la transparencia y información proporcionada a los usuarios, la supervisión humana, la solidez, la precisión y las disposiciones de ciberseguridad. Serán evaluados antes de su comercialización y a lo largo de su ciclo de vida. Tendrán obligaciones estrictas, como supervisión humana y el uso de datos de alta calidad para evitar la discriminación.

También con luz amarilla se establecen sistemas de IA de Riesgo Limitado asociados con la falta de transparencia en su uso. Estarán sujetos a menores obligaciones legales. Por ejemplo, cuando se utilizan sistemas de IA como chatbots, los seres humanos deben ser conscientes de que están interactuando con una máquina para que puedan tomar una decisión informada de continuar o dar un paso atrás.. Los proveedores también tendrán que asegurarse de que el contenido generado por IA sea identificable, “El error de mi Bot, es mi error”. Se añaden los sistemas de inteligencia artificial generativa, en los que se basan modelos como ChatGPT, que tendrán que cumplir criterios de transparencia, como especificar si un texto, una canción o una fotografía se han generado a través de la inteligencia artificial y garantizar que los datos que se han empleado para entrenar a los sistemas respetan los derechos de autor.

Por último, semaforo verde para los sistemas de I.A de Riesgo Mínimo, cuyo uso libre está permitido. Incluye aplicaciones como videojuegos habilitados para IA o filtros de spam. No estarán sujetos a ninguna obligación, aunque se recomienda la adopción de códigos de conducta voluntarios, una autorregulación.

Como la primera propuesta legislativa de su tipo a nivel mundial, esta regulación de la inteligencia artificial establece un estándar crucial para futuras normativas en todo el mundo. En este contexto, es fundamental que países como Argentina y nuestras provincias, aborden de manera proactiva y responsable la adopción de medidas que se alineen con esta normativa modelo, garantizando los derechos, la seguridad y la innovación en el uso de IA dentro de nuestras fronteras.

Es crucial que tanto las autoridades provinciales como los actores del sector privado estén al tanto de estas regulaciones, el sistema de semáforos para el diseño de la regulación, implementación y presente al analizar las consecuencias de los daños que puede generar una actividad con uso de esta herramienta. Esto no solo asegurará la conformidad legal, sino que también contribuirá a crear un entorno favorable para el desarrollo responsable y ético de la IA, maximizando sus beneficios, mitigando posibles riesgos, generando responsables ante posibles daños de cruce luz roja o amarilla.

* Abogada, Directora del Instituto de Derecho e I.A. del Colegio de Abogados y Procuradores de Neuquén.

Comentarios